本文作者罗超 编辑 reMake

世界杯期间各家科技巨头利用大数据预测比赛结果,再现“章鱼保罗”雄风。世界杯结束了但大数据预测还会继续。从夜观天象到气象预报,从童话里的水晶球到今日的科技预言家,从地震云的传说再到科学家猛攻的地震预测,人类一直希望能够更早突破局限看穿未来。随着信息革命的深入,大数据时代的预测更加容易,人类的生活正在被大数据预测深刻改变。

预测是大数据核心价值

人们在谈论大数据的采集、存储和挖掘时,最常见的应用案例便是“预测股市”“预测流感”“预测消费者行为”,预测性分析是大数据最核心的功能。

大数据还拥有数据可视化和大数据挖掘的功能,对已发生的信息价值进行挖掘并辅助决策。传统的数据分析挖掘在做相似的事情,只不过效率会低一些或者说挖掘的深度、广度和精度不够。大数据预测则是基于大数据和预测模型去预测未来某件事情的概率。让分析从“面向已经发生的过去”转向“面向即将发生的未来”是大数据与传统数据分析的最大不同。

大数据预测的逻辑基础是,每一种非常规的变化事前一定有征兆,每一件事情都有迹可循,如果找到了征兆与变化之间的规律,就可以进行预测。大数据预测无法确定某件事情必然会发生,它更多是给出一个概率。

从天气预报看大数据预测的四个条件

在互联网之前便已经有基于大数据的预测分析了:天气预报。因为互联网,天气预报为代表的大数据预测的以下几个特征在更多领域得到体现。

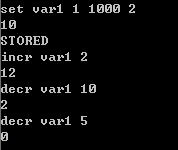

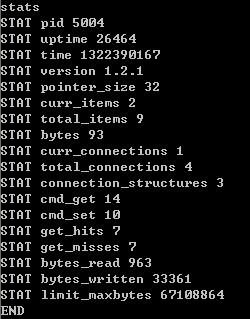

1、大数据预测的时效性。天气预报粒度从天缩短到小时,有严苛的时效要求,基于海量数据通过传统方式进行计算,得出结论时明天早已到来,预测并无价值。其他领域的大数据预测应用特征对“时效性”有更高要求,譬如股市、实时定价,而云计算、分布式计算和超级计算机的发展则提供了这样的高速计算能力。

2、大数据预测的数据源。天气预报需要收集海量气象数据,气象卫星、气象站台负责收集,但整套系统的部署和运维耗资巨大。在互联网之前鲜有领域具备这样的数据收集能力。WEB1.0为中心化信息产生、WEB2.0为社会化创造、移动互联网则是随时随地、社会化和多设备的数据上传,每一次演化数据收集的成本都大幅降低,范围和规模则大幅扩大。大数据被引爆的同时,大数据预测所需数据源不再是问题。

3、大数据预测的动态性。不同时点的计算因子动态变化,任何变量都会引发整个系统变化,甚至产生蝴蝶效应。如果某个变量对结果起决定性作用且难以捕捉,预测难上加难,譬如人为因素。大数据预测的应用场景大都是极不稳定的领域但有固定规律,譬如天气、股市、疾病。这需要预测系统对每一个变量数据的精准捕捉,并接近实时地调整预测。发达的传感器网络外加大数据计算能力让上述两点更加容易。

4、大数据预测的规律性。大数据预测与传统的基于抽样的预测不同之处在于,其基于海量历史数据和实时动态数据,发现数据与结果之间的规律,并假设此规律会延续,捕捉到变量之后进行预测。一个领域本身便有相对稳定的规律,大数据预测才有机会得到应用。古人夜观天象就说明天气是由规律可循的,因此气象预报最早得到应用。反面案例则是规律难以捉摸,数据源收集困难的地震预测,还有双色球彩票。

大数据预测的典型应用领域

互联网给大数据预测应用的普及带来了便利条件。天气预报之外,还有哪些领域正在或者可能被大数据预测所改变呢?结合国内外案例来看,以下11个领域是最有机会的大数据预测应用领域。

1、体育赛事预测

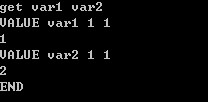

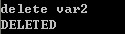

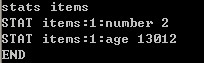

世界杯期间,谷歌、百度、微软和高盛等公司都推出了比赛结果预测平台。百度预测结果最为亮眼,预测全程 64 场比赛,准确率为 67%,进入淘汰赛后准确率为 94%。现在互联网公司取代章鱼保罗试水赛事预测也意味着未来的体育赛事会被大数据预测所掌控。

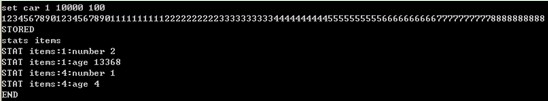

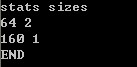

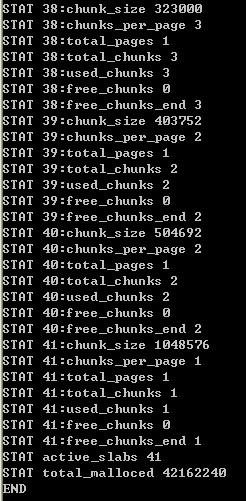

Google 世界杯预测基于 Opta Sports 的海量赛事数据来构建其最终的预测模型。百度则是搜索过去 5 年内全世界 987 支球队(含国家队和俱乐部队)的 3.7 万场比赛数据,同时与中国彩票网站乐彩网、欧洲必发指数数据供应商 Spdex 进行数据合作,导入博彩市场的预测数据,建立了一个囊括 199972 名球员和 1.12 亿条数据的预测模型,并在此基础上进行结果预测。

从互联网公司的成功经验来看,只要有体育赛事历史数据,并且与指数公司进行合作,便可以进行其他赛事的预测,譬如欧冠、NBA等赛事。

2、股票市场预测

去年英国华威商学院和美国波士顿大学物理系的研究发现,用户通过谷歌搜索的金融关键词或许可以金融市场的走向,相应的投资战略收益高达 326%。此前则有专家尝试通过 Twitter 博文情绪来预测股市波动。

理论上来讲股市预测更加适合美国。中国股票市场无法做到双向盈利,只有股票涨才能盈利,这会吸引一些游资利用信息不对称等情况人为改变股票市场规律,因此中国股市没有相对稳定的规律则很难被预测,且一些对结果产生决定性影响的变量数据根本无法被监控。

3、市场物价预测

CPI 表征已经发生的物价浮动情况,但统计局数据并不权威。但大数据则可能帮助人们了解未来物价走向,提前预知通货膨胀或经济危机。最典型的案例莫过于马云通过阿里 B2B 大数据提前知晓亚洲金融危机,当然这是阿里数据团队的功劳。

单个商品的价格预测更加容易,尤其是机票这样的标准化产品,去哪儿提供的“机票日历”就是价格预测,告知你几个月后机票的大概价位。商品的生产、渠道成本和大概毛利在充分竞争的市场中是相对稳定的,与价格相关的变量相对固定,商品的供需关系在电子商务平台可实时监控,因此价格可以预测,基于预测结果可提供购买时间建议,或者指导商家进行动态价格调整和营销活动以利益最大化。

5、用户行为预测

基于用户搜索行为、浏览行为、评论历史和个人资料等数据,互联网业务可以洞察消费者的整体需求,进而进行针对性的产品生产、改进和营销。《纸牌屋》选择演员和剧情、百度基于用户喜好进行精准广告营销、阿里根据天猫用户特征包下生产线定制产品、亚马逊预测用户点击行为提前发货均是受益于互联网用户行为预测。

受益于传感器技术和物联网的发展,线下的用户行为洞察正在酝酿。免费商用WIFI、ibeacon技术、摄像头影像监控、室内定位技术、NFC 传感器网络、排队叫号系统,可以探知用户线下的移动、停留、出行规律等数据,进行精准营销或者产品定制。

6、人体健康预测

中医可以通过望闻问切手段发现一些人体内隐藏的慢性病,甚至看体质便可知晓一个人将来可能会出现什么症状。人体体征变化有一定规律,而慢性病发生前人体已经会有一些持续性异常。理论上来说,如果大数据掌握了这样的异常情况,便可以进行慢性病预测。

结合智能硬件,慢性病的大数据预测变为可能。可穿戴设备和智能健康设备帮助网络收集人体健康数据,心率、体重、血脂、血糖、运动量、睡眠量等状况。如果这些数据足够精准且全面,并且有可以形成算法的慢性病预测模式,或许未来你的设备就会提醒你的身体罹患某种慢性病的风险。KickStarter 上的 My Spiroo 便可收集哮喘病人的吐气数据来指导医生诊断其未来的病情趋势。急性病却很难预测,突变和随机性特征使之难以预测。

7、疾病疫情预测

基于人们的搜索情况、购物行为预测大面积疫情爆发的可能性,最经典的“流感预测”便属于此类。如果来自某个区域的“流感”、“板蓝根”搜索需求越来越多,自然可以推测该处有流感趋势。

继世界杯、高考、景点和城市预测之后,百度近日推出了疾病预测产品。目前可以就流感、肝炎、肺结核、性病这四种疾病,对全国每一个省份以及大多数地级市和区县的活跃度、趋势图等情况,进行全面的监控。未来,百度疾病预测监控的疾病种类将从目前的4种扩展到30多种,覆盖更多的常见病和流行病。用户可以根据当地的预测结果进行针对性的预防。

8、灾害灾难预测

气象预测是最典型的灾难灾害预测。地震、洪涝、高温、暴雨这些自然灾害如果可以利用大数据能力进行更加提前的预测和告知便有助于减灾防灾救灾赈灾。与过往不同的是,过去的数据收集方式存在着死角、成本高等问题,物联网时代可以借助廉价的传感器摄像头和无线通信网络,进行实时的数据监控收集,再利用大数据预测分析,做到更精准的自然灾害预测。

9、环境变迁预测

除了进行短时间微观的天气、灾害预测之外,还可以进行更加长期和宏观的环境和生态变迁预测。森林和农田面积缩小、野生动物植物濒危、海岸线上升,温室效应这些问题是地球面临的“慢性问题“。如果人类知道越多地球生态系统以及天气形态变化数据,就越容易模型化未来环境的变迁,进而阻止不好的转变发生。而大数据帮助人类收集、储存和挖掘更多的地球数据,同时还提供了预测的工具。

10、交通行为预测

基于用户和车辆的 LBS 定位数据,分析人车出行的个体和群体特征,进行交通行为的预测。交通部门可预测不同时点不同道路的车流量进行智能的车辆调度,或应用潮汐车道;用户则可以根据预测结果选择拥堵几率更低的道路。

百度基于地图应用的 LBS 预测涵盖范围更广。春运期间预测人们的迁徙趋势指导火车线路和航线的设置,节假日预测景点的人流量指导人们的景区选择,平时还有百度热力图来告诉用户城市商圈、动物园等地点的人流情况,指导用户出行选择和商家的选点选址。

11、能源消耗预测

加州电网系统运营中心管理着加州超过 80% 的电网,向 3500 万用户每年输送 2.89 亿兆瓦电力,电力线长度超过 25000 英里。该中心采用了 Space-Time Insight 的软件进行智能管理,综合分析来自包括天气、传感器、计量设备等各种数据源的海量数据,预测各地的能源需求变化,进行智能电能调度,平衡全网的电力供应和需求,并对潜在危机做出快速响应。中国智能电网业已在尝试类似大数据预测应用。

对于单个家庭来说则可以通过智能家居设备,记录家庭成员的起居习惯,感知用户的舒适度,预测用户的温控能耗需求,进行智能的温控装置控制,还可结合阶梯电价表来帮助用户省钱。Nest正式基于大数据预测用户能耗需求的成功产品。

除了上面列举的 10 多个领域之外,大数据预测还可被应用在房地产预测、就业情况预测、高考分数线预测、选举结果预测、奥斯卡大奖预测、保险投保者风险评估、金融借贷者还款能力评估等等,让人类具备可量化有说服力可验证的洞察未来的能力,大数据预测的魅力正在释放出来。

作者微博@互联网阿超,微信SuperSofter

创之(chuang.pro)是TECH2IPO/创见旗下创业主题子站,为创业者、投资人提供最有价值资讯和观点,欢迎你与我们共同建设!